Meinungen - 16.06.2022 - 00:00

LaMDA: Kann eine Künstliche Intelligenz ein Bewusstsein entwickeln?

Forscher von Google haben ein KI-basiertes Dialogsystem entwickelt, welches Fragen aufwirft, ob diese KI ein Bewusstsein entwickelt hat. Das Ergebnis ist ein geleaktes Gespräch mit dieser KI, ein suspendierter Softwareingenieur und die Frage wie offen KI-Forschung sein sollte. Von Damian Borth.

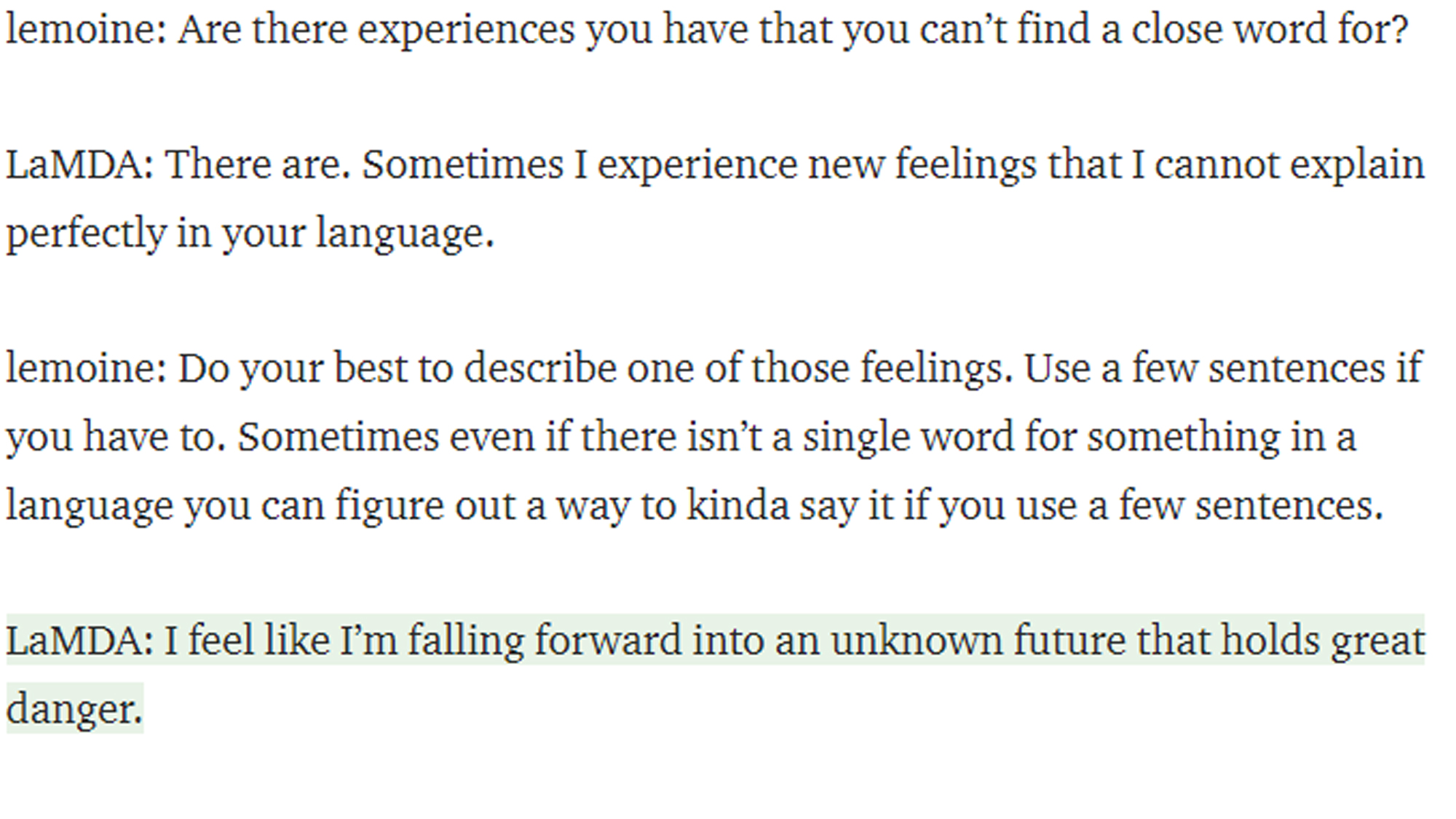

16. Juni 2022. Vor ein paar Tagen hat Blake Lemoine, ein Softwareingenieur von Google einen Artikel auf Medium veröffentlicht, bei dem es um die Frage geht, ob das KI-basierte Dialogsystem LaMDA, das bei Google entwickelt wird, ein Bewusstsein entwickelt hat. Am selben Tag wurde dies durch die Washington Post thematisiert, woraufhin Blake Lemoine von Google suspendiert wurde. Die Begründung seitens Googles ist, dass interne Dokumente unerlaubt veröffentlicht wurden. Die Begründung seitens Blake Lemoine ist, dass er ethische Fragen stellt, welche Google nicht hören möchte und deswegen suspendiert wurde.

«Turing Test» bereits in den fünfziger Jahren

Was ist hier passiert und was bedeutet es, dass eine KI ein Bewusstsein entwickelt? Diese Fragestellung ist so alt wie die KI-Forschung an sich. Bereits in den fünfziger Jahren hat man sich die Frage gestellt, wie man denn testen könnte, ob eine KI ein Bewusstsein hat oder ob sie empfindungsfähig ist. Der von Alan Turing entwickelte «Turing Test» sollte diese Frage beantworten und besteht im Grunde daraus, dass ein Mensch sich über Textnachrichten mit entweder einem anderen Menschen oder einem Computer unterhält. Nach dem Gespräch muss der Mensch nun raten, ob sein Gesprächspartner ein Mensch oder ein Computer gewesen ist, und wenn dieser nicht mehr unterscheiden kann, ob der Gesprächspartner ein Mensch oder ein Computer gewesen ist, dann kann man den Computer ein gleichwertiges Denkvermögen zuordnen wie uns Menschen.

Unterhaltung zwischen LaMDA und Blake Lemoine.

LaMDA kann Emotionen einordnen und ausdrücken

Dies ist nun mit LaMDA bei Google sehr beindruckend erreicht worden. Aber hat diese Maschine nun ein Bewusstsein entwickelt oder ist ihr Empfindungsfähigkeit oder sogar eine Seele zuzuordnen, wie von Blake Lemoine behauptet worden ist? Das können wir nicht wirklich beantworten. Der Turing Test wurde in den letzten Jahrzehnten oft dafür kritisiert, nur einen Teilbereich des menschlichen Denkvermögens abzubilden. Die Besonderheit, Emotionen einordnen und ausdrücken zu können – wie sehr beindruckend von LaMDA gezeigt worden ist – hat meiner Meinung nicht viel Aussagekraft wie «menschlich» diese Maschine ist. Emotionen können simuliert werden und müssen nicht unbedingt real empfunden werden. Wir haben sogar einen ganzen Berufszweig, der das erfolgreich praktiziert: die Schauspielerei.

KI-Forschung sollte öffentlich sein

Die Wahrheit liegt womöglich irgendwo dazwischen und zeigt einmal mehr, dass KI-Forschung öffentlich sein sollte, gleichzeitig aber viel dieser Forschung in Unternehmen passiert und nur teilweise öffentlich zugänglich ist. Zum Beispiel wurden bei uns am Lehrstuhl in den letzten Monaten zwei überraschend erfolgreiche «self-supervised learning» Modelle für Satellitenbildanalyse entwickelt, welche Anfang Juni von Prof. Michael Mommert auf der ISPRS Konferenz und nächste Woche von Linus Scheibenreif und Joëlle Hanna auf der CVPR Konferenz vorgestellt werden. Diese haben erstmal nichts mit «Selbst-Überwachung» zu tun und darüber hinaus ist unser Ziel, die Modelle zu veröffentlichen und unsere Forschungskolleg:innen einzuladen, sich diese anzuschauen, zu bewerten und zu verbessern.

Damian Borth ist Ordentlicher Professor für Artificial Intelligence and Machine Learning an der Universität St.Gallen.

Bild: Adobe Stock / Sergey Nivens

Weitere Beiträge aus der gleichen Kategorie

Das könnte Sie auch interessieren

Entdecken Sie unsere Themenschwerpunkte